Von 0,11 Megapixeln bis zu Assistenten für neuronale Netze: Wie sich Kameras in Smartphones entwickelt haben

Geräte / / January 06, 2021

Die Kamera in einem Smartphone ist zu einem festen Bestandteil unseres Lebens geworden: Mit ihrer Hilfe können Sie immer einen wichtigen Moment festhalten und mit anderen teilen. Um dies zu erreichen, waren jedoch 20 Jahre technischer Fortschritt, Umverteilung des Marktes für Fotoausrüstung und viele Innovationen erforderlich. Wir haben uns daran erinnert, wie die mobile Fotografie in unseren Alltag eindrang und welche Unternehmen sie einfach und zugänglich machten.

Die ersten Kamerahandys

Zum ersten Mal erschien die Kamera 1999 im Telefon: Die japanische Firma Kyocera veröffentlichte das Modell VP-210, mit dem Videoanrufe getätigt werden konnten. Die Kamera befand sich vorne und nahm das Gesicht des Besitzers mit einer Geschwindigkeit von 2 Bildern pro Sekunde auf. Sie könnte auch Selfies mit einer Auflösung von 0,11 Megapixeln aufnehmen und diese in einer Menge von bis zu 20 Teilen im Speicher des Geräts speichern.

In den folgenden Jahren entwickelten sich mobile Kameras unter dem Ansturm des Wettbewerbs rasant, und bereits 2004 wurde der Meilenstein von 1 Million Pixel (1 Megapixel) erreicht. Und 2005 war der Markt von zwei Modellen schockiert, die als erste Kamerahandys bezeichnet werden können: Nokia N90 und Sony Ericsson k750i. Sie hatten 2-Megapixel-Autofokus-Kameras und machten scharfe Bilder, keine verschwommenen Abstraktionen. Zu diesem Zeitpunkt begann sich die Einstellung der Benutzer zur mobilen Fotografie zu ändern: Auf Flickr erschienen thematische Gruppen, die Menschen begannen, auf ihren Handys empfangene Bilder auszutauschen und sie zu diskutieren.

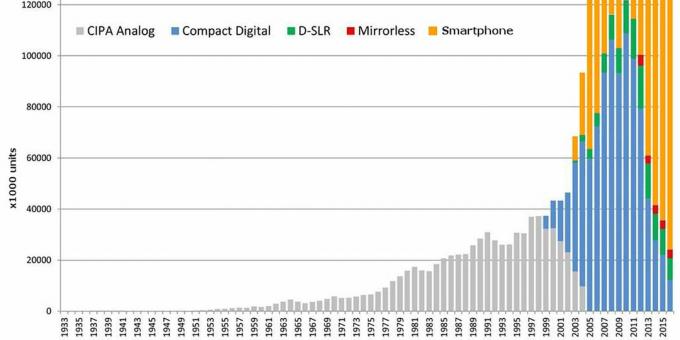

Mit jedem folgenden Jahr ist die Anzahl der Personen, die mit ihren Handys Fotos machen, exponentiell gestiegen. Die Veröffentlichung des iPhone im Jahr 2007 veränderte die Einstellung zu monofunktionalen Geräten: Smartphones ersetzten MP3-Player und dann Amateur-Foto- und Videokameras.

Lese jetzt🔥

- 25 lustige Google-Suche Ostereier, die Sie vielleicht nicht kennen

Morgendämmerung von Instagram

Der Zusammenbruch des Kameramarktes erfolgte 2010 mit dem Start des Instagram-Dienstes. Benutzer wollten ein attraktives Foto so einfach und schnell wie möglich erhalten und in sozialen Netzwerken veröffentlichen.

Gleichzeitig verbesserte sich die Qualität mobiler Kameras. Das 2011 eingeführte iPhone 4s verfügt über eine 8-Megapixel-Kamera und eine lichtempfindliche Optik mit einer Blende von 1: 2,4. Diese Eigenschaften deckten die meisten Anforderungen ab: Sie drücken den Knopf, erhalten einen hellen Rahmen und laden ihn ein Instagram.

Im Laufe der Zeit ist die Verarbeitung von Bildern in Smartphones aggressiver geworden: Kontrast, Sättigung und Konturschärfe haben Priorität, und die Natürlichkeit des Bildes tritt in den Hintergrund. Es gab aber auch Versuche, professionelle Technologien für mobile Kameras bereitzustellen. So stellte Nokia 2012 das 808 PureView-Kamerahandy her.

Das Modell zeichnete sich durch für seine Zeit phänomenale Eigenschaften aus. Die Kameraauflösung betrug 41 Megapixel und die physikalische Größe des Sensors betrug 1 / 1,2 ". Es war auch mit einem mechanischen Verschluss, einem eingebauten ND-Filter, einem Carl Zeiss-Objektiv mit 1: 2,4-Blende und Xenon-Blitz ausgestattet.

Leider hatten andere Hersteller es nicht eilig, dem Beispiel von Nokia zu folgen und sich auf Filter und andere Dekorationen zu verlassen.

Mehr Kameras, gut und anders

Irgendwann beschlossen die Unternehmen, die Anzahl der Kameras in Smartphones zu erhöhen. Bereits 2011 wurden das HTC Evo 3D und das LG Optimus 3D veröffentlicht, bei denen jeweils zwei Objektive zur Erstellung stereoskopischer Fotos verwendet wurden. Die Technologie erwies sich jedoch als nicht beansprucht und die Hersteller vergaßen solche Experimente für mehrere Jahre.

Im Frühjahr 2014 wurde auf dem Markt das HTC One M8 vorgestellt. Das Smartphone erhielt ein Hilfsmodul zur Tiefenmessung und Trennung des Objekts vom Hintergrund. So implementierte das Unternehmen den Porträtmodus zwei Jahre früher als Apple.

Ein echter Boom ereignete sich 2016, als die größten Hersteller ihre Lösungen vorstellten. Gleichzeitig gab es keine einheitliche Ansicht darüber, was ein Smartphone benötigt zwei Kameras. Zum Beispiel hat Huawei die monochrome Fotografie mit dem P9 beworben, das es gemeinsam mit Leica entwickelt hat. Das LG G5 setzte auf Shirik, während Apple im iPhone 7 Plus ein Teleobjektiv für Porträtfotografie und optischen Zoom einführte.

Wie sich herausstellte, sind zwei Kameras nicht die Grenze. Mittlerweile sind fast alle Smartphones auf dem Markt mit drei Objektiven mit unterschiedlichen Brennweiten sowie Kameras für die Makrofotografie und Tiefenmessung ausgestattet.

Zunehmende Eigenschaften

Die Qualität mobiler Kameras war immer durch physikalische Einschränkungen eingeschränkt: Aufgrund der geringen Dicke des Gehäuses konnten Smartphones nicht mit hochwertigen Optiken und großen Sensoren ausgestattet werden. Die Nutzer forderten jedoch Verbesserungen, die Unternehmen versuchten, ihre Bedürfnisse zu befriedigen.

So entstanden Kameras, die einige Millimeter aus dem Körper herausragen. Die physikalischen Abmessungen von Sensoren sind ebenfalls gewachsen: Wenn sie vor fünf Jahren innerhalb von 1/3 Zoll schwankten, sind sie jetzt auf dem Markt erschienen Samsung Galaxy S20 Ultra und Huawei P40 mit 1 / 1,3-Zoll-Sensoren. Die Bildsensoren haben sich fast neunmal erhöht, was die Qualität der Fotos erheblich verbessert hat.

Die große Fläche der Sensoren ermöglichte es, die Auflösung zu erhöhen. Mobile Kameras mit 48 MP und 64 MP sind zur Norm geworden, während Samsung und Xiaomi habe bereits die 108 Megapixel Linie genommen. Fotos mit einer solchen Auflösung wiegen jedoch zu viel, weshalb sich die Ingenieure für einen Trick entschieden haben: Informationen aus benachbarten Pixeln werden kombiniert. Dies verringert die Auflösung, aber im Gegenzug erhalten wir weniger Rauschen und einen größeren Dynamikbereich.

Was weiter

All diese Innovationen haben Smartphones zu einem idealen Ersatz für digitale Seifenschalen gemacht. Trotzdem haben sie noch Raum zum Wachsen. Und selbst wenn die physikalischen Eigenschaften an die Decke stoßen, wird Software immer zur Rettung kommen.

Jetzt gewinnt die Computerfotografie an Fahrt: Die Kamera nimmt eine Reihe von Bildern auf, und Neuronale Netze Auf ihrer Basis sammeln sie den idealen Rahmen, unterdrücken Rauschen, gleichen die Helligkeit aus und korrigieren die Farbe. Die Methode wird in Google Pixel 4, iPhone 11, Huawei P40 und vielen anderen Smartphones verwendet. Die Verarbeitung erfolgt automatisch und unmerklich für den Benutzer - er sieht nur das Ergebnis.

Mit zunehmender Produktivität werden die Funktionen von Kameras erweitert. Sie können bereits Videos aufnehmen und in Echtzeit verarbeiten: Verwischen Sie den Hintergrund oder machen Sie ihn schwarzweiß, sodass Objekte in Farbe bleiben. Die Richtung der Augmented Reality entwickelt sich ebenfalls: Apple hat das iPad Pro bereits mit einem LiDAR-Sensor für die Arbeit mit AR-Anwendungen ausgestattet, und bald wird die Technologie auf dem iPhone erscheinen.

Mobile Kameras werden zu einem Hardware-Software-Komplex, dessen Funktionen wir nicht vollständig verstehen. Deshalb ist es interessanter, die neuesten Entwicklungen in diesem Bereich zu verfolgen und selbst zu testen.

Lesen Sie auch📸

- Beste Smartphone-Kameras von 2019 von DxOMark

- So machen Sie ein gutes Foto: 6 Grundprinzipien

- 9 Vorteile eines Dreifachkamera-Smartphones